十多年前三位人工智能研究人员取得的一项突破,永久性地改变了人工智能领域。

他们创造了一个名为“AlexNet”的卷积神经网络系统,并采用 120 万张网络图片来训练这个系统。最终,该系统成功地识别了诸如货柜船、美洲豹之类的各种物体,准确度远超以往的图像识别系统。

三位开发人员分别是亚历克斯・克里日夫斯基(Alex Krizhevsky)、伊利亚・萨茨基弗(Ilya Sutskever)和杰弗里・辛顿(Geoffrey Hinton)。他们凭借这项发明在 2012 年度的 ImageNet 图像辨识竞赛中获胜。AlexNet 的研制成功,使得科技界开始认识到机器学习的潜力,并就此带来了一场人工智能革命。

很大程度上,这场人工智能革命是一个静悄悄的常人并不注意的革命。对于基于机器学习的人工智能在未来可能接管所有人类工作的前景,大部分人在不久前还对此一无所知。机器学习是一项涉及计算机从大量数据中学习的底层技术,已被广泛应用于许多过去只能由人类完成的工作中,比如信用卡欺诈识别和在线内容关联广告等。

但近期,人工智能领域又取得了一项波及到整个人类社会的突破,使得这场革命不再如过去那般静悄悄 —— 人们终于意识到,自己的“饭碗”正受到人工智能的威胁。

ChatGPT 引爆新一轮人工智能革命

这一突破的代表事例之一就是 ChatGPT,一个在去年 11 月底发布的问答文本生成系统。这样的系统过去一般只在科幻小说中见到,但现在,它已走进了公众视野,成为光芒闪耀的存在。

ChatGPT 由美国人工智能研究机构 OpenAI 所创建,是大热的所谓生成式人工智能系统中最新同时也最引人注目的一个。这种生成式人工智能可以按照人类发出的指令来生成相应的内容。AlexNet 的创建者之一伊利亚・萨茨基弗正是 OpenAI 的联合创始人。

据悉,如果在 ChatGPT 中输入一个问题,它将生成一段简明扼要的文字,这段文字包含了问题答案和相关的背景知识。例如,当问它是谁赢得了 2020 年的美国总统选举,它会告诉你是乔・拜登在选举中获胜,此外,它还会额外告诉你拜登是何时开始就职的。

ChatGPT 使用简单,问题输入后瞬时就生成问题答案,看起来就像是一个正常人类在和你进行交流。正是因为这个特性,人工智能现在很有希望走进人们的日常生活。截至目前,微软已向 OpenAI 投资了数十亿美元,这也足以说明该技术的看好度。ChatGPT 很有可能在这场人工智能革命的下一阶段扮演中心角色。

不过,ChatGPT 只是近期一系列引人注目的人工智能成果中的一项。OpenAI 的另一个人工智能系统,即自动写作系统 GPT-3,在 2020 年首次演示时就已经让科技界为之震惊。此后,其他公司也很快推出了各自的大型语言模型系统。然后,人工智能技术在去年进一步扩展到图像生成领域,代表产品包括 OpenAI 的 Dall-E2、Stability AI 的开源型 Stable Diffusion,以及 Midjourney 等系统。

随着这些技术成果的出现,人们开始蜂拥为这些技术寻找各种新的应用场景。预料新应用将会大量出现,可能足以比拟史前寒武纪时期的生命形态大爆发。

如果计算机能学会写作和绘画,那还有什么是它们做不到的呢?最近,人工智能已开始实验性地应用于视频生成(Google)、数学问题回答(Google)、音乐创作(Stability AI)、代码生成等领域。制药公司也计划利用人工智能技术来针对性地辅助设计新药物。已有生物技术公司利用人工智能来设计新抗体,并大大缩短了临床前测试所需的时间。

人工智能将彻底改变人类与计算机互动的方式,它将以一种前所未有的方式来理解人类意图,并采取相应的行动。人工智能将成为一项基础性的技术,触及人类社会的所有方面。

随着人工智能日益广泛的应用,人们需要考虑该技术可能给人类社会带来的负面影响。例如,ChatGPT 可能会被青少年利用来代替他们完成家庭作业。更严重的是,人工智能可能被故意用来产生大量虚假信息。此外,它还可以将许多人类工作自动化,这可能会造成严重的失业问题。

人工智能是否可靠?

认同生成式人工智能的人士认为,这些系统可以提高人类的生产力和创造力。对于任何需要创意性的工作而言,生成式人工智能系统有助于人们破除思想束缚,并向工作人员建议新想法,协助检查工作,乃至帮助生产大量内容。然而,尽管“生成式”人工智能易于使用,并有可能颠覆大部分技术领域,但它对公司和个人都提出了深刻的挑战。

人工智能带给人类的最大挑战在于可靠性。人工智能系统能够生成看起来很可信的结果,但事实上未必是那么回事。人工智能是根据海量数据按照概率原理来做出最佳猜测并形成问题答案。但是,对它们所生成的结果,人工智能并不具备人类思维意义上的那种真正理解。

人工智能无法记住与人类的对话,他们并不真正理解人类,对现实世界中的文字符号没有任何概念。人工智能只是根据人类发出的指令,给出看起来很有说服力的回应。它们是既聪明又无脑的人类模仿者,它们的结果输出只是一种数字幻觉。

已经有迹象表明,该技术可能产生看起来可信但并不值得信赖的结果。例如,去年底,Facebook 母公司 Meta 展示了一个名为 Galactica 的生成式系统,该系统使用学术论文作为数据集来进行训练。很快,人们就发现,该系统可按要求生成看起来可信但实际上完全虚假的研究结果。于是,Meta 不得不在几天后就撤回了这一系统。

ChatGPT 的创建者也承认,该系统有时会给出很荒谬的答案,这是因为在训练人工智能时,无法保证数据集的真理性 / 正确性。OpenAI 称,所谓的监督式学习(即在人类监督下接受训练,而不是让它自学训练)对 ChatGPT 并不奏效,因为该系统往往比它的人类老师更善于找到 “理想的答案”。

一个可能的解决方案是在结果输出之前对结果进行合理性检查。Google 在 2021 年发布的实验性 LaMDA 系统,对每个人类指令都给出了大约 20 个不同回应,然后 Google 对每一个回应的安全性和可靠性(groundedness)都进行评估。然而,有专家认为,任何依靠人类来验证人工智能输出结果的系统都可能会带来更多问题。比如,这可能教会人工智能去产生有欺骗性但看起来更可信的内容,从而再次愚弄人类。真相有时难以捉摸,而人类并不十分擅长探究真相,因而,靠人类来评估人工智能的输出结果也并不一定靠谱。

也有专家认为,对诸如输出结果是否合理之类的哲学式问题其实无需多虑,只需要专注于人工智能技术的实用价值就行。比如,互联网搜索引擎的输出有时也同样包含错误信息和有用结果,但人们自己会对结果进行鉴别,并从中找出对他们有用的东西。人们需要学会鉴别性的使用这些人工智能工具,以从中受益。当然,孩子们不能利用这些系统来在学校舞弊。

但是,实践表明,让人们去自行鉴别“生成式”人工智能的输出结果,可能并不是一个好主意,原因是人们往往过度相信人工智能的输出结果 —— 他们会不自觉地将人工智能当作真正的人来看待,而忘记了这些系统其实并不真正理解人类的意思。

由此看来,人工智能的可靠性可能的确是一个问题。这项技术有可能会被不良人士蓄意利用,成为虚假信息生成工厂,虚假信息可能因此充斥社交媒体平台。人工智能还可能被用于模仿特定人士的写作风格或说话声音。总之,虚假内容的制作将变得前所未有的容易、廉价且无限制。

Stability AI 的总裁埃玛德・莫斯塔克(Emad Mostaque)对此表示,可靠性问题是人工智能与生俱来的内在问题。人们既可以以一种合乎道德法律的方式去使用这项技术,也可以不道德不合法地使用它。他声称,居心不良的人士必然会利用这些先进的人工智能工具,对此唯一的防范措施就是尽可能广泛地传播该技术,以及对所有人开放这项技术。

但是,在专业人士眼里,人工智能技术的广泛传播,究竟是否可以有效防范该技术的负面效应,仍有很大争议。许多专家主张,应该限制对人工智能基础技术的访问。来自微软的人士就表示,他们公司会与客户紧密沟通,以了解他们对该技术的使用情况,确保人工智能得到负责任的使用。

此外,微软也尽力防止利用它的人工智能产品做不良事情的行为。该公司会为客户提供必要的工具,以扫描输出结果中的攻击性内容,以及客户不想见到的特定内容。这家公司深刻认识到,人工智能也会出现行为异常:就在 2016 年,微软在推出智能聊天机器人 Tay 仅仅一天后,就不得不匆忙撤回这款产品,原因是这个机器人向用户输出种族主义等偏激言论。

在某种程度上,技术本身就有可能抑制住人工智能的滥用。例如,Google 已经开发出一个语言系统,能够以 99% 的准确率检测一段语音是否是用人工智能合成。Google 所有在研的人工智能模型都禁止生成真实人物的图像,这对预防深度伪造(deep fake)将起到一定作用。

人类的工作是否会被大量取代?

随着生成式人工智能的横空出世,人们再次开始激辩人工智能对人类工作的影响。智能机器是否会大量取代人类工作?又或者,通过接管人类工作中的程序性部分,人工智能反而提高了人类的生产力,并进一步提高成就感?

涉及大量设计 / 写作元素的职业和工作岗位将面临着人工智能的直接冲击。去年夏末,Stability AI 推出了人工智能文本转图像模型“Stable Diffusion”。这个模型可以根据人类提供的文字描述瞬时生成相匹配的图像。这款人工智能工具给整个商业艺术界和设计界都带来了一阵恐慌。

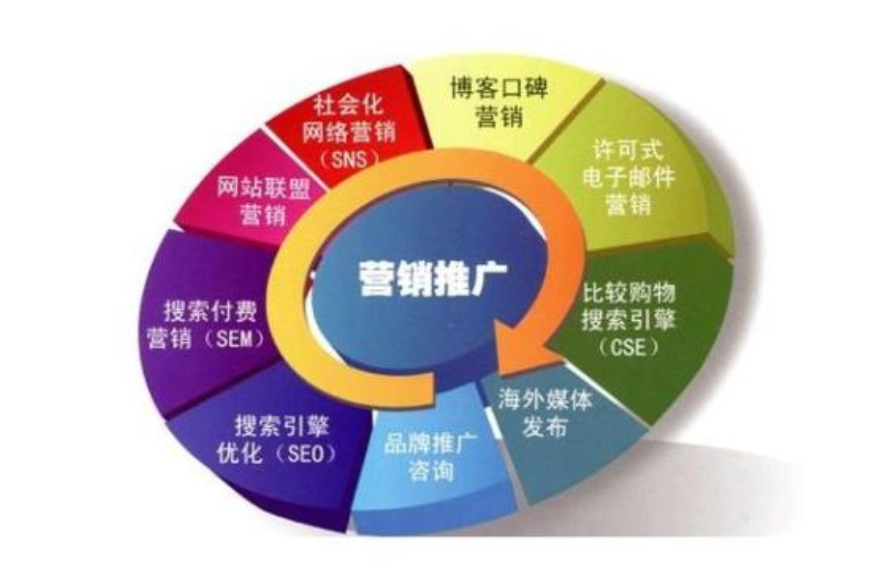

一些科技公司已经在尝试将“生成式”人工智能应用于广告业。这方面的代表公司是 Scale AI,它正在使用广告图片来训练一个人工智能模型。这个模型可能用于为小型零售商和小品牌制作专业的产品广告图片,从而为商家节省广告制作费用。

总之,人工智能有可能影响到那些内容创作人士的生计。这项技术彻底改变了整个媒体行业。全球的主要内容供应商都认为,他们需要一个元宇宙战略,同时也需要一个“生成式”媒体战略。

部分处于被人工智能取代边缘的创作人士认为,问题并不仅仅止于他们的工作生计,还有更深层次的东西。一位音乐家在看到 ChatGPT 创作的很像他的风格的歌曲时,他是如此的震惊,以至于他在网上发出了如下感叹:音乐家是在痛苦中创作音乐,这种创作建立在复杂的内心苦痛的基础之上,但对人工智能而言,它们没有人类的感觉,感受不到人类的痛苦。

技术乐观主义者的看法则有所不同。他们认为,人工智能并不会取代人类的创造力,反而可以增强人类的创造力。比如,在过去,设计师仅能一幅幅地去创作单一图片,但在有了人工智能图像生成器后,他就可以更多聚焦于整个视频或整个作品集的创作了。

不过,现有的版权制度对创作人士并不是很有利。采用人工智能技术的公司声称,美国允许“合理使用”(fair use)受版权保护的材料,因此他们可以免费利用所有可用的数据来训练他们的系统。但许多艺术家及相关团体对此非常不满,他们认为,人工智能公司使用他们的艺术作品来训练人工智能,是对这一版权特许权利的滥用。就在上周,盖蒂图片社(Getty Images)和三位艺术家对 Stability AI 和其他人工智能公司采取了法律行动。这是创作界首次针对人工智能训练数据问题采取行动。

一名代理人工智能公司应诉的律师说,人工智能业界都已清楚,法律诉讼不可避免,也为此做好了准备。这些诉讼事关数据在人工智能中的地位问题,将确立相关的基本规则 —— 这对科技行业的影响并不亚于当年智能手机刚兴起时的专利大战。

从根本上,法院和立法者将扮演为人工智能时代的版权制度确立基本框架的角色。如果他们认为人工智能技术已经颠覆了现有版权制度的基础,那么版权制度就将面临变革。